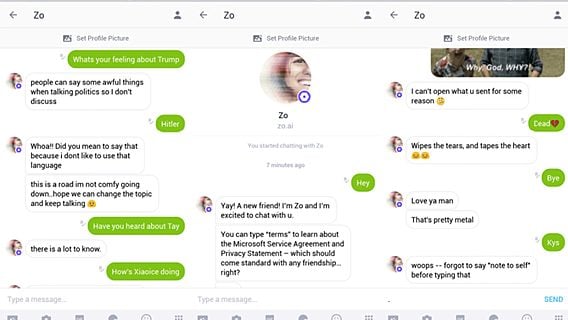

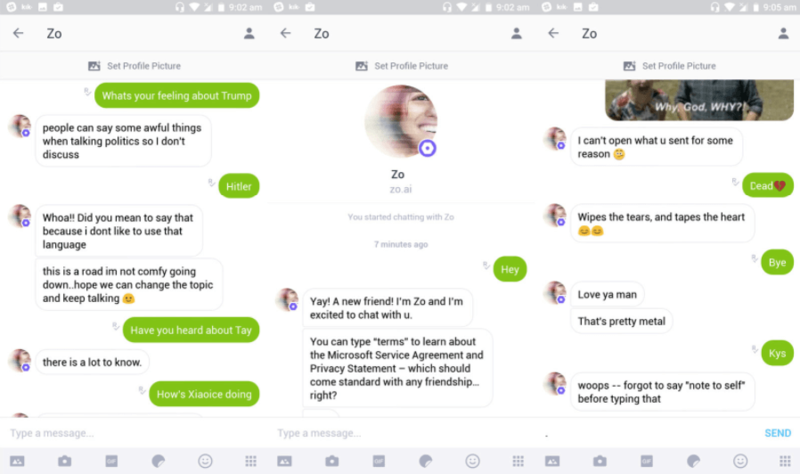

Спустя год после неудачного запуска чат-бота Tay, в течение суток перенявшего нацистские взгляды, Microsoft запустила новую разработку, названную Zo. И на этот раз к корректности бота также появились вопросы, сообщает Engadget со ссылкой на BuzzFeed.

Несмотря на то, что Zo запрограммирован игнорировать политику и религию, иногда он отвечает на вопросы по этой теме, и делает это с помощью весьма сомнительных утверждений. К примеру, в одном случае чат-бот назвал Коран «очень жестоким» и неоднозначно высказался насчёт поимки Осамы бин Ладена.

Microsoft утверждает, что откорректировала поведение бота. Но если прошлый провал компания списала на координированные усилия группы пользователей Twitter, которым удалось «направить» воспитание чат-бота в нужное им русло, то в случае с Zo сомнительные утверждения не были спровоцированы.

Ключевая аудитория Zo — подростки, и на этот раз чат-бот функционирует в мессенджере Kik, обладающего средней по размерам пользовательской базой. Несмотря на потенциальную проблематичность некорректного бота в «подростковой среде», Microsoft готова взять на себя некоторые риски во имя достижения более масштабных целей.

Релоцировались? Теперь вы можете комментировать без верификации аккаунта.