The New York Times начала использовать алгоритмы машинного обучения для обнаружения и удаления агрессивных и грубых комментариев к статьям, сообщает Poynter.

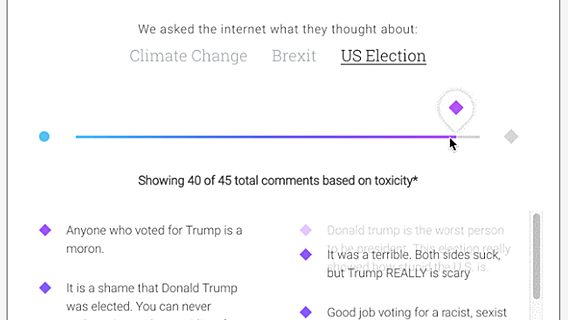

Издание использует инструмент Perspective, созданный в технологическом инкубаторе Jigsaw, принадлежащем Alphabet. Алгоритмы изучают многочисленные комментарии к статьям на сайте NYT и скрывают те из них, которые посчитают особо грубыми или оскорбительными.

Сейчас около 10 процентов статей открыты для комментариев. С инструментом Perspective в издании надеются увеличить количество «открытых» публикаций до 25 процентов за счёт освобождения времени редакторов, ответственных за обратную связь пользователей. Согласно плану, в итоге комментарии должны появиться в 80 процентах статей.

Если раньше процесс модерации предполагал прочтение каждого комментария человеком, то теперь «токсичность» пользовательских сообщений будет определять Perspective, а модераторы будут принимать решения на основе оценки программы.

«Мощь машинного обучения даёт нам возможность вернуть обсуждения в интернете в нормальное русло, «развернув» тренд на закрытие комментирования», — отмечает CEO Jigsaw Джаред Коэн.

В планах создателей технологии — расширить доступ к продукту, открыв доступ к API уже в ближайшие месяцы.

Релоцировались? Теперь вы можете комментировать без верификации аккаунта.